PyTorch چیست؟ و چه کاربردی دارد؟

PyTorch یک کتابخانه محاسبات عددی متن باز برای پایتون است که از تواناییهای محاسبات تانسوری چند بعدی بهره میبرد. این کتابخانه برای توسعه شبکههای عصبی عمیق (Deep Neural Networks) و انجام محاسبات علم داده (Scientific Computing) استفاده میشود. PyTorch به عنوان یکی از ابزارهای محبوب برای پژوهشهای مربوط به یادگیری عمیق شناخته میشود و از امکاناتی مانند اتوماتیکسازی محاسبات مشتقگیری (Automatic Differentiation) برخوردار است که میتواند فرآیند آموزش شبکههای عصبی را سریعتر و آسانتر کند.

آیا PyTorch با دیگر کتابخانههای یادگیری ماشین سازگار است؟

PyTorch با بسیاری از دیگر کتابخانهها و ابزارهای مرتبط با یادگیری ماشین سازگار است. این کتابخانهها میتوانند به عنوان ابزارهای تکمیلی برای توسعه و آموزش مدلهای یادگیری عمیق با PyTorch استفاده شوند. برخی از کتابخانهها و ابزارهایی که ممکن است با PyTorch استفاده شوند عبارتند از:

- TorchVision: یک زیرمجموعه از PyTorch که شامل مجموعهای از ابزارها و دادههای مرتبط با بینایی ماشین است.

- TorchText: یک کتابخانه برای پردازش زبان طبیعی (NLP) که با PyTorch سازگار است.

- PyTorch Lightning: یک کتابخانه سطح بالا برای آموزش مدلهای PyTorch که فرآیند آموزش را سادهتر و مدیریت پروژههای بزرگتر را آسانتر میکند.

- TensorFlow: اگرچه TensorFlow و PyTorch دو کتابخانه جداگانه هستند، اما شما میتوانید از TensorFlow با PyTorch استفاده کنید، به عنوان مثال برای انتقال داده بین این دو کتابخانه.

- Scikit-learn: یک کتابخانه محبوب برای یادگیری ماشین در پایتون که میتواند به عنوان ابزار تکمیلی برای پیشپردازش دادهها یا ارزیابی مدلها در ارتباط با PyTorch استفاده شود.

با استفاده از این کتابخانهها و ابزارها، میتوانید از تواناییهای PyTorch بهترین استفاده را برد و پروژههای یادگیری ماشین خود را بهبود دهید.

کاربرد های PyTorch

PyTorch ویژگیهای بسیاری دارد که آن را یکی از محبوبترین و قدرتمندترین کتابخانههای یادگیری عمیق میکنند. برخی از ویژگیهای اصلی PyTorch عبارتند از:

- اتوماتیکسازی محاسبات مشتقگیری: PyTorch از یک سیستم محاسبه مشتقهای اتوماتیک بهره میبرد که به شما این امکان را میدهد که به راحتی مشتقهای توابع خود را محاسبه کنید، که یک قابلیت بسیار مهم در آموزش مدلهای یادگیری عمیق است.

- پرتابهای (Tensors) قابل تنظیم: PyTorch از ساختمان دادهای به نام “پرتاب” برای نگهداری دادهها استفاده میکند که شبیه به آرایههای Numpy هستند، اما قابلیت انجام عملیات مشتقگیری بر روی آنها را دارند.

- پشتیبانی از GPU: PyTorch امکان انتقال محاسبات به GPU را فراهم میکند که این امر باعث افزایش سرعت آموزش مدلهای عمیق میشود.

- پشتیبانی از شبکههای عصبی پیچشی (Convolutional Neural Networks) و بازگردنده (Recurrent Neural Networks): PyTorch ابزارهای مختلفی برای ساخت و آموزش این نوع از شبکهها فراهم میکند.

- پشتیبانی از انواع معماریهای مدل: PyTorch از مدلهای مختلفی از شبکههای عصبی از جمله شبکههای پیچشی، شبکههای بازگردنده، شبکههای تماممتصل و غیره پشتیبانی میکند.

- ادغام با کتابخانههای دیگر: PyTorch میتواند با کتابخانهها و ابزارهای دیگر مانند TensorFlow، NumPy، Scikit-learn و … همکاری کند.

- پشتیبانی از انواع دستگاههای محاسباتی: PyTorch از CPU، GPU و حتی TPU (Tensor Processing Units) برای انجام محاسبات پشتیبانی میکند.

این ویژگیها به کاربران اجازه میدهند تا مدلهای یادگیری عمیق پیچیده را ایجاد و آموزش دهند و از قابلیتهای پیشرفته محاسباتی PyTorch بهره ببرند.

PyTorch از چه دادههایی پشتیبانی می کند؟

PyTorch از انواع مختلف دادهها برای پردازش در شبکههای عصبی عمیق پشتیبانی میکند. این انواع دادهها شامل انواع مختلف تنسورها (tensors)، تصاویر، صدا، متن و سایر دادههای متداول در پردازش تصویر و یادگیری عمیق است.

انواع دادههایی که PyTorch از آنها پشتیبانی میکند شامل:

- Tensors (تنسورها): این نوع دادهها معادل با آرایههای چند بعدی هستند که به صورت مستقیم در PyTorch استفاده میشوند. تنسورها اصلیترین نوع داده برای نمایش دادهها و محاسبات در PyTorch هستند.

- تصاویر: PyTorch از تصاویر به عنوان ورودی یا خروجی شبکههای عصبی عمیق پشتیبانی میکند. میتوانید تصاویر را به صورت تنسورها یا با استفاده از کتابخانههای مربوطه به صورت ماتریسهای تصویری (image tensors) در PyTorch بارگیری و پردازش کنید.

- صدا (Audio): PyTorch امکان پردازش دادههای صوتی را نیز فراهم میکند. شما میتوانید دادههای صوتی را به صورت تنسورها یا ساختارهای دادهای خاص برای صدا در PyTorch بارگیری و پردازش کنید.

- متن (Text): برای پردازش متن و انجام وظایف مرتبط با پردازش زبان طبیعی، PyTorch از ساختارهای دادهای متنی مانند جملات، کلمات، واژگان و بردارهای ویژگی متنی (word embeddings) پشتیبانی میکند.

PyTorch به شما امکان میدهد که از این انواع دادهها به عنوان ورودی و خروجی برای مدلهای خود استفاده کنید و در عملیات مختلف یادگیری عمیق و پردازش تصویر، صدا، و متن از آنها بهره ببرید.

اجزای PyTorch

PyTorch یک کتابخانه محاسباتی باز مبتنی بر تانسور (tensor) برای پایتون است که برای توسعه مدلهای یادگیری عمیق استفاده میشود. ساختار اصلی PyTorch شامل چند بخش اصلی است که این اجزا با هم تعامل میکنند تا مدلهای یادگیری عمیق ساخته و آموزش داده شوند. به طور کلی، اجزای اصلی PyTorch عبارتند از:

Tensor (پرتاب):

- پرتابها (tensors) در PyTorch معادل آرایههای Numpy هستند و برای نگهداری دادهها و انجام محاسبات بر روی آنها استفاده میشوند.

- این تانسورها میتوانند در CPU یا GPU محاسبات شوند و امکان محاسبه مشتقها نیز بر روی آنها وجود دارد.

Module (ماژول):

- ماژولها در PyTorch اجزای اصلی برای ساخت مدلهای یادگیری عمیق هستند.

- هر ماژول میتواند شبکههای عصبی مختلفی از جمله لایهها، توابع فعالسازی، و … را شامل شود.

Optimizer (بهینهساز):

- بهینهسازها در PyTorch برای به روزرسانی پارامترهای مدلهای یادگیری عمیق با استفاده از گرادیانهای محاسبه شده وجود دارند، مانند SGD، Adam، و …

Loss Function (تابع خطا):

- توابع خطا برای ارزیابی عملکرد مدلهای یادگیری عمیق و محاسبه خطای پیشبینیها توسط مدل استفاده میشوند.

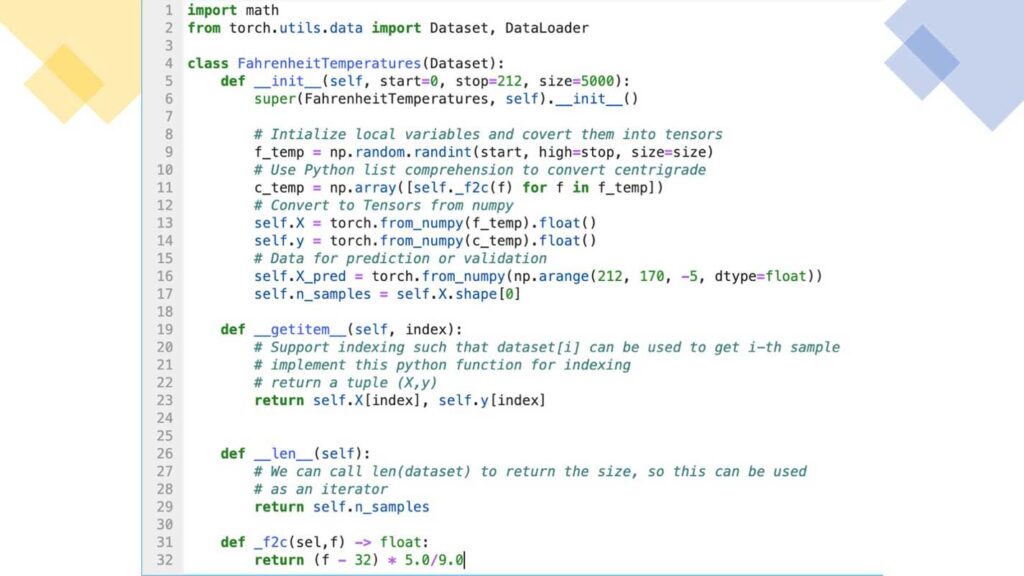

DataLoader (بارگیر داده):

- این اجزا برای بارگیری و پیشپردازش دادهها برای آموزش و ارزیابی مدلها استفاده میشوند.

Autograd (اتوماتیکسازی محاسبات مشتقگیری):

- این قابلیت اتوماتیک مشتقگیری در PyTorch به شما اجازه میدهد تا گرادیانهای لازم برای بهینهسازی پارامترهای مدلهای خود را به طور اتوماتیک محاسبه کنید.

این اجزای اصلی به کاربران اجازه میدهند تا مدلهای یادگیری عمیق پیچیده را ساخته و آموزش دهند و از امکانات PyTorch در ایجاد و بهینهسازی مدلهای خود بهره ببرند.

آموزش نصب PyTorch

برای نصب PyTorch، میتوانید از دستورات pip یا conda استفاده کنید، به ترتیب برای نصب از PyPI یا Anaconda/Miniconda. در ادامه نحوه نصب PyTorch با استفاده از دستورات pip و conda را برای سیستمعاملهای مختلف آوردهام:

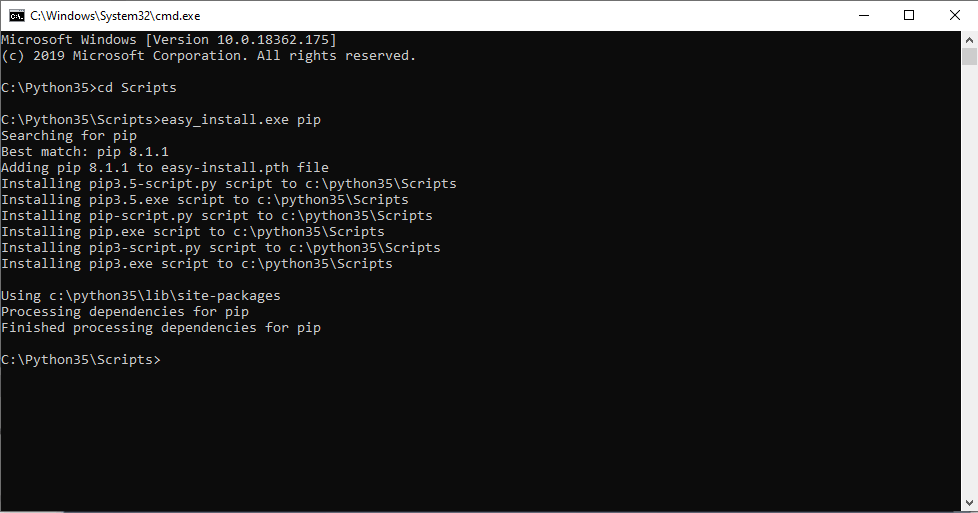

استفاده از pip برای نصب PyTorch:

با GPU:

pip install torch torchvision torchaudio

بدون GPU:

pip install torch torchvision torchaudio -f https://download.pytorch.org/whl/torch_stable.html

استفاده از conda برای نصب PyTorch:

با GPU:

conda install pytorch torchvision torchaudio cudatoolkit=11.1 -c pytorch

بدون GPU:

conda install pytorch torchvision torchaudio cpuonly -c pytorch

نصب PyTorch برای سیستمعاملهای مختلف:

Windows:

برای نصب PyTorch در ویندوز، میتوانید از PowerShell یا Command Prompt استفاده کنید.

macOS:

در مک، میتوانید از ترمینال یا نرمافزار Anaconda Navigator استفاده کنید.

Linux:

در لینوکس نیز میتوانید از ترمینال یا محیط آناکوندا استفاده کنید.

با اجرای دستورات فوق، PyTorch و ماژولهای مربوطه برای یادگیری عمیق روی سیستم شما نصب خواهد شد. اطمینان حاصل کنید که محیط مجازی خود را فعال کرده و از نسخه مطابق با نیازهای پروژهی خود استفاده میکنید.

مثالهایی از توابع خطا در PyTorch

البته، در PyTorch مجموعهای از توابع خطا یا loss functions برای محاسبه خطاها و ارزیابی عملکرد مدلهای یادگیری عمیق در اختیار کاربران قرار دارد. در زیر چند نمونه از توابع خطا معمول در PyTorch آورده شده است:

MSE Loss (Mean Squared Error Loss):

- این تابع خطا برای مسائل رگرسیون استفاده میشود و خطای میانگین مربعات تفاضل بین پیشبینی مدل و مقادیر واقعی را محاسبه میکند.

- کد مثال:

criterion = nn.MSELoss()

loss = criterion(output, target)Cross-Entropy Loss:

- این تابع خطا برای مسائل طبقهبندی استفاده میشود و خطای منطقی بین پیشبینی مدل و برچسبهای واقعی را محاسبه میکند.

- کد مثال:

criterion = nn.CrossEntropyLoss()

loss = criterion(output, target)BCE Loss (Binary Cross-Entropy Loss):

- این تابع خطا برای مسائل طبقهبندی دودویی استفاده میشود و برای محاسبه خطای مدل در پیشبینی دو کلاس مختلف استفاده میشود.

- کد مثال:

criterion = nn.BCELoss()

loss = criterion(output, target)NLL Loss (Negative Log Likelihood Loss):

- این تابع خطا برای مسائل طبقهبندی استفاده میشود و خطای منفی لگاریتم احتمال برای هر کلاس را محاسبه میکند.

- کد مثال:

criterion = nn.NLLLoss()

loss = criterion(output, target)این توابع خطا به کاربران اجازه میدهند تا عملکرد مدلهای خود را ارزیابی کرده و خطاهای مدل را محاسبه کنند تا در فرآیند آموزش مدل اصلاحات لازم انجام دهند.

آموزش یک شبکه عصبی پیچشی برای تشخیص تصاویر

برای آموزش یک شبکه عصبی پیچشی برای تشخیص تصاویر با استفاده از PyTorch، شما به تعریف مدل، انتخاب دادهها، تعریف دادههای آموزش، تعریف تابع خطا و بهینهساز، و اجرای فرآیند آموزش نیاز دارید. در زیر یک مثال کامل برای آموزش یک شبکه عصبی پیچشی برای تشخیص تصاویر با استفاده از دادههای CIFAR-10 آورده شده است:

import torch

import torch.nn as nn

import torch.optim as optim

import torchvision

import torchvision.transforms as transforms

# تعریف تبدیلات پیشپردازش برای دادهها

transform = transforms.Compose([

transforms.ToTensor(),

transforms.Normalize((0.5, 0.5, 0.5), (0.5, 0.5, 0.5))

])

# بارگیری دادههای CIFAR-10

trainset = torchvision.datasets.CIFAR10(root='./data', train=True, download=True, transform=transform)

trainloader = torch.utils.data.DataLoader(trainset, batch_size=4, shuffle=True)

# تعریف مدل شبکه عصبی پیچشی

class Net(nn.Module):

def __init__(self):

super(Net, self).__init__()

self.conv1 = nn.Conv2d(3, 6, 5)

self.pool = nn.MaxPool2d(2, 2)

self.conv2 = nn.Conv2d(6, 16, 5)

self.fc1 = nn.Linear(16 * 5 * 5, 120)

self.fc2 = nn.Linear(120, 84)

self.fc3 = nn.Linear(84, 10)

def forward(self, x):

x = self.pool(F.relu(self.conv1(x)))

x = self.pool(F.relu(self.conv2(x)))

x = x.view(-1, 16 * 5 * 5)

x = F.relu(self.fc1(x))

x = F.relu(self.fc2(x))

x = self.fc3(x)

return x

net = Net()

# تعریف تابع خطا و بهینهساز

criterion = nn.CrossEntropyLoss()

optimizer = optim.SGD(net.parameters(), lr=0.001, momentum=0.9)

# آموزش مدل

for epoch in range(2): # تعداد دورههای آموزش

running_loss = 0.0

for i, data in enumerate(trainloader, 0):

inputs, labels = data

optimizer.zero_grad()

outputs = net(inputs)

loss = criterion(outputs, labels)

loss.backward()

optimizer.step()

running_loss += loss.item()

if i % 2000 == 1999: # چاپ وضعیت آموزش هر ۲۰۰۰ داده

print('[%d, %5d] loss: %.3f' % (epoch + 1, i + 1, running_loss / 2000))

running_loss = 0.0

print('آموزش پایان یافت')در این مثال، ابتدا تبدیلات پیشپردازش برای دادهها تعریف شده و سپس دادههای CIFAR-10 بارگیری شده و به شکل دستههایی برای آموزش ارائه میشوند. سپس یک مدل شبکه عصبی پیچشی ساده تعریف شده و فرآیند آموزش با استفاده از تابع خطا CrossEntropyLoss و بهینهساز SGD انجام میشود.

شما میتوانید این کد را در یک فایل Python ذخیره کرده و با اجرای آن، آموزش شبکه عصبی پیچشی برای تشخیص تصاویر را انجام دهید.

استفاده از یک مدل یادگیری عمیق پیشآموزش دیده برای تشخیص تصاویر

استفاده از یک مدل یادگیری عمیق پیشآموزش دیده برای تشخیص تصاویر میتواند بهبود عملکرد شبکهی شما را به نسبت یک مدل از ابتدا آموزش دیده، ارائه دهد. شبکههایی مانند ResNet، VGG، Inception و MobileNet از مدلهای یادگیری عمیق پیشآموزش دیده معروف هستند که میتوانید از آنها برای تشخیص تصاویر استفاده کنید.

در زیر یک مثال از استفاده از مدل ResNet-50 پیشآموزش دیده ارائه شده است:

import torch

import torch.nn as nn

import torch.optim as optim

import torchvision

from torchvision import models, transforms

# تعریف تبدیلات پیشپردازش برای دادهها

transform = transforms.Compose([

transforms.Resize(256),

transforms.CenterCrop(224),

transforms.ToTensor(),

transforms.Normalize(mean=[0.485, 0.456, 0.406], std=[0.229, 0.224, 0.225]),

])

# بارگیری دادههای ImageNet به عنوان دادههای پیشآموزش

pretrained_model = models.resnet50(pretrained=True)

pretrained_model.eval()

# تعریف تغییرات لایه آخر برای تطبیق با تعداد کلاسهای مورد نظر شما

num_ftrs = pretrained_model.fc.in_features

pretrained_model.fc = nn.Linear(num_ftrs, num_classes)

# آموزش تنظیمی روی دادههای خود

# اضافه کردن فاز آموزش و تعریف تابع خطا و بهینهساز

pretrained_model.train()

criterion = nn.CrossEntropyLoss()

optimizer = optim.SGD(pretrained_model.parameters(), lr=0.001, momentum=0.9)

# آموزش مدل

for inputs, labels in train_loader:

optimizer.zero_grad()

outputs = pretrained_model(inputs)

loss = criterion(outputs, labels)

loss.backward()

optimizer.step()

print('آموزش پایان یافت')در این مثال، ابتدا مدل ResNet-50 پیشآموزش دیده از دادههای ImageNet بارگیری شده و سپس لایه آخر آن با یک لایه خطی جایگزین شده است تا به تعداد کلاسهای مورد نظر شما تطبیق یابد. سپس تابع خطا و بهینهساز تعریف شده و مدل با دادههای خود آموزش داده میشود.

شما میتوانید این کد را با دادههای خود و شبکههای یادگیری عمیق دیگر نیز استفاده کنید تا یک مدل قوی برای تشخیص تصاویر ایجاد کنید.

جمع بندی:

PyTorch یک ابزار قدرتمند و انعطافپذیر برای یادگیری عمیق است. این کتابخانه به دلیل سادگی و خوانایی کدها، پشتیبانی از محاسبات گرافهای پویا و استفاده از GPU، بین پژوهشگران و برنامهنویسان محبوبیت زیادی پیدا کرده است. PyTorch به شما این امکان را میدهد تا مدلهای پیچیده یادگیری عمیق را به راحتی پیادهسازی و آموزش دهید و در پروژههای خود به کار ببرید.

مقالهای که ارائه دادید، انگیزهبخش و مفید بود. امیدوارم که این توضیحات به شما کمک کند تا با PyTorch و قابلیتهای آن آشنا شوید و بتوانید با اطمینان و انگیزه بیشتر، به پروژههای یادگیری عمیق خود با استفاده از این کتابخانه مشغول شوید.