نصب و استفاده از Open WebUI: اجرای مدلهای زبانی هوش مصنوعی به صورت محلی

Open WebUI یک پلتفرم متنباز و خودمیزبان (self-hosted) است که به شما امکان میدهد مدلهای زبانی هوش مصنوعی را روی سیستم خود با کنترل کامل بر دادههایتان اجرا کنید. این پلتفرم از مدلهای محلی مانند Ollama و همچنین APIهای سازگار با OpenAI پشتیبانی میکند. شما میتوانید Open WebUI را با استفاده از Docker، Python یا Kubernetes خودمیزبان کنید. در اینجا، فرآیند گامبهگام نصب Open WebUI روی ماشین محلی را نشان میدهیم.

چرا از Open WebUI استفاده کنیم؟

Open WebUI راهی آسان و انعطافپذیر برای استفاده از هوش مصنوعی به روش دلخواه شما ارائه میدهد. این پلتفرم از مدلهای مختلف هوش مصنوعی پشتیبانی میکند و روی هر سیستمعامل اصلی کار میکند. رابط کاربری آن شبیه به ChatGPT است و ویژگیهایی مانند Markdown، LaTeX، افزونهها و سیستم حافظه داخلی برای ذخیره محتوای مفید ارائه میدهد.

شما میتوانید افزونهها را ادغام کنید، APIها را متصل کنید و چندین چت را بهطور همزمان مدیریت کنید. علاوه بر این، میتوانید پرامپت هایتان را ذخیره کنید تا بهترین ایدههایتان آماده استفاده باشند. بهعنوان یک ابزار متنباز، بهسرعت تکامل مییابد و همیشه به ویژگیها و بهبودهای جدید دسترسی خواهید داشت.

نصب Open WebUI

برای نصب Open WebUI با استفاده از Docker، ابتدا باید یک دایرکتوری پروژه ایجاد کنید و به آن بروید:

mkdir openwebui cd openwebui

اکنون، یک فایل docker-compose.yml در هر ویرایشگری مانند Notepad ایجاد کنید:

nano docker-compose.yml

محتوای زیر را در فایل docker-compose.yml جایگذاری کنید:

services:

ollama:

image: ollama/ollama:latest

container_name: ollama

ports:

- "۱۱۴۳۴:۱۱۴۳۴"

environment:

- OLLAMA_USE_GPU=false

volumes:

- ollama_data:/root/.ollama

restart: unless-stopped

openwebui:

image: ghcr.io/open-webui/open-webui:main

container_name: openwebui

ports:

- "۳۰۰۰:۸۰۸۰"

environment:

- OLLAMA_BASE_URL=http://ollama:11434

depends_on:

- ollama

volumes:

- open-webui:/app/backend/data

restart: unless-stopped

volumes:

open-webui:

ollama_data:

این فایل Docker Compose دو سرویس را اجرا میکند: ollama و Open WebUI. سرویس ollama از تصویر ollama/ollama استفاده میکند، روی پورت ۱۱۴۳۴ گوش میدهد، استفاده از GPU را غیرفعال میکند و دادهها را در حجم ollama_data ذخیره میکند. از سوی دیگر، Open WebUI از ایمیج open-webui استفاده میکند، پورت ۳۰۰۰ را به ۸۰۸۰ مپ میکند، از طریق URL پایه به ollama متصل میشود و دادهها را در ولوم open-webui ذخیره میکند. هر دو سرویس تا زمانی که متوقف نشوند، بهطور خودکار راهاندازی مجدد میشوند و volumeهای نامگذاریشده دادهها را پایدار نگه میدارند.

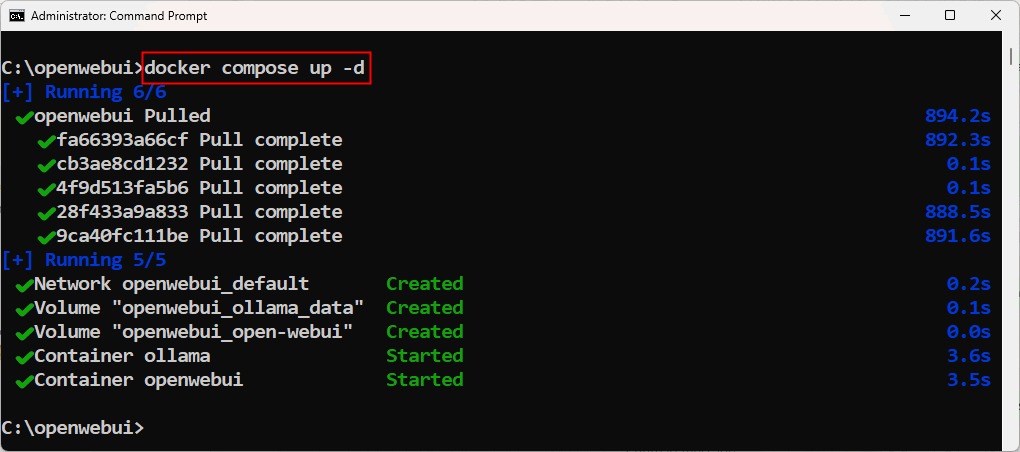

فایل docker-compose را ذخیره کنید و سرویس Docker را شروع کنید:

docker compose up -d

دسترسی و استفاده از Open WebUI

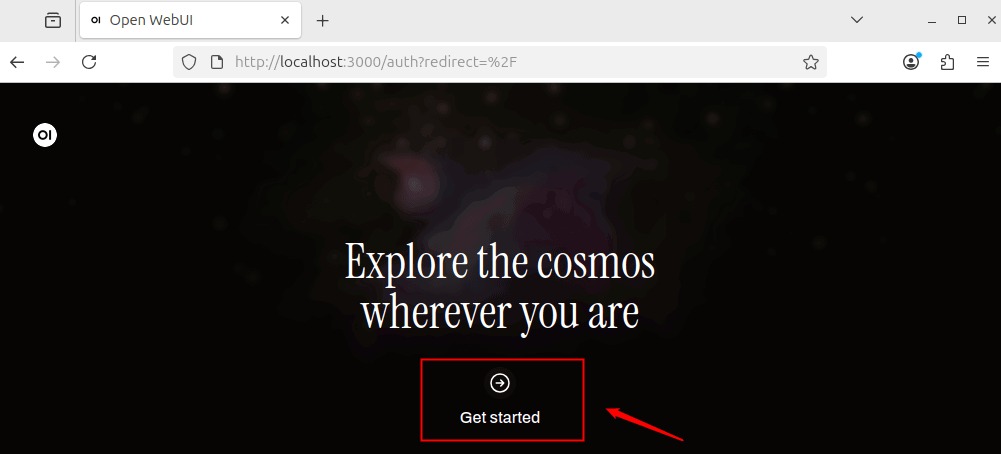

پس از شروع کانتینرها، یک مرورگر وب باز کنید و به آدرس http://localhost:3000 بروید. رابط کاربری Open WebUI از ماشین محلی شما بارگذاری میشود. روی دکمه Get Started کلیک کنید تا با تنظیمات Open WebUI ادامه دهید.

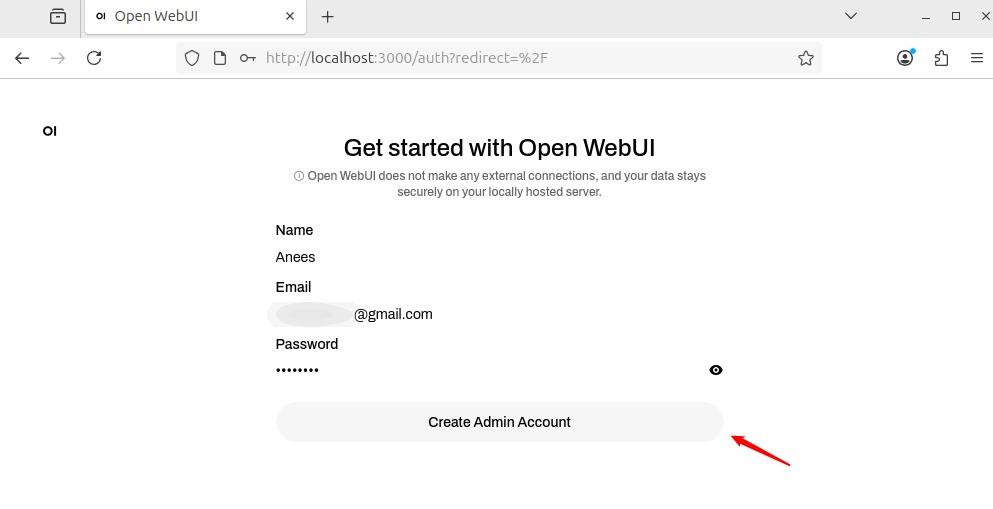

نام، ایمیل و رمز عبور خود را وارد کنید و سپس روی دکمه Create Admin Account کلیک کنید تا حساب ادمین خود را ایجاد کنید.

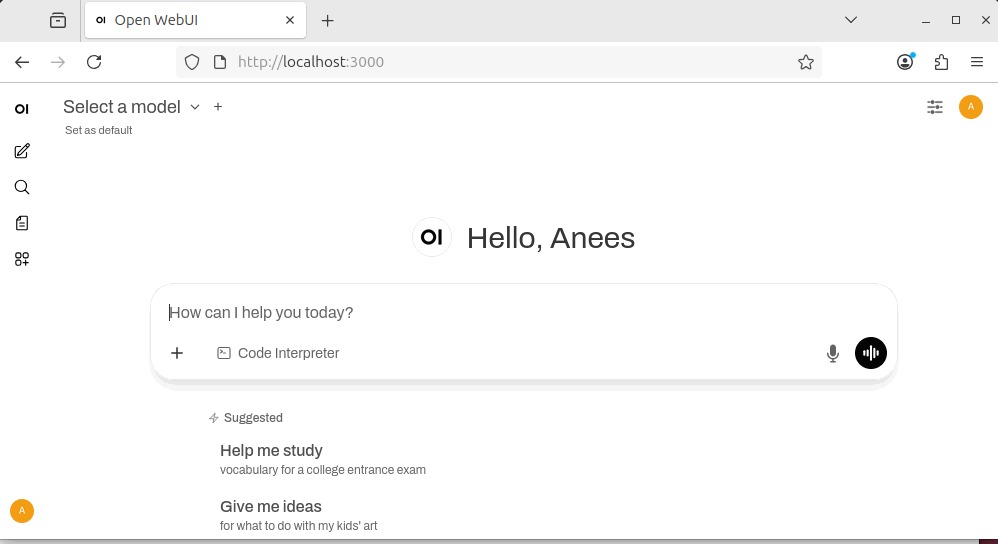

پس از ایجاد حساب، میتوانید وارد شوید تا به داشبورد دسترسی پیدا کنید.

نصب مدل هوش مصنوعی از طریق Ollama

Open WebUI فقط رابط کاربری را فراهم میکند. شما همچنان باید حداقل یک مدل هوش مصنوعی محلی نصب کنید تا کار کند. خوشبختانه، Open WebUI این کار را از طریق Ollama آسان میکند. میتوانید مدلهای مختلفی مانند llama3، mistral، gemma یا vicuna را بسته به نیازها و منابع سیستمی خود نصب کنید.

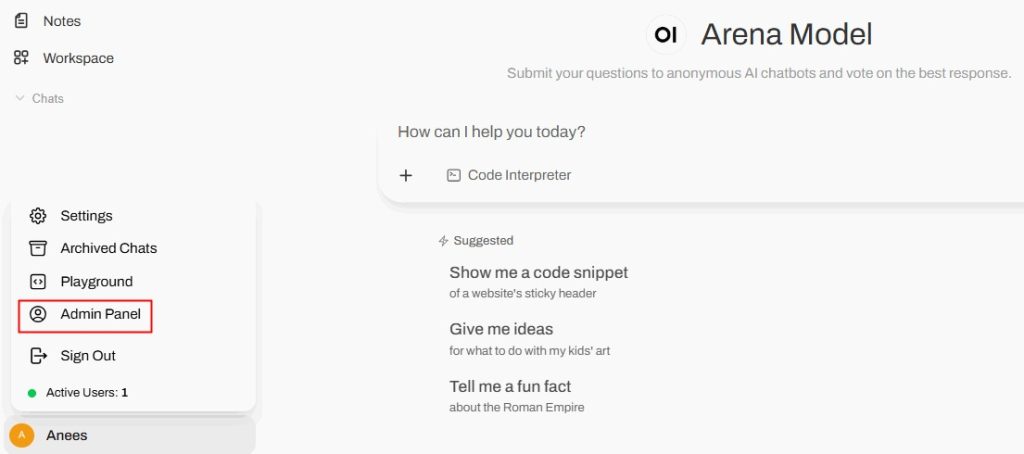

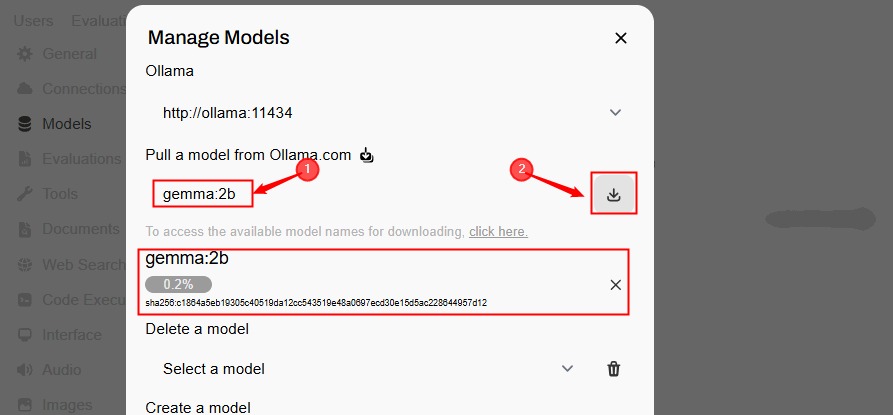

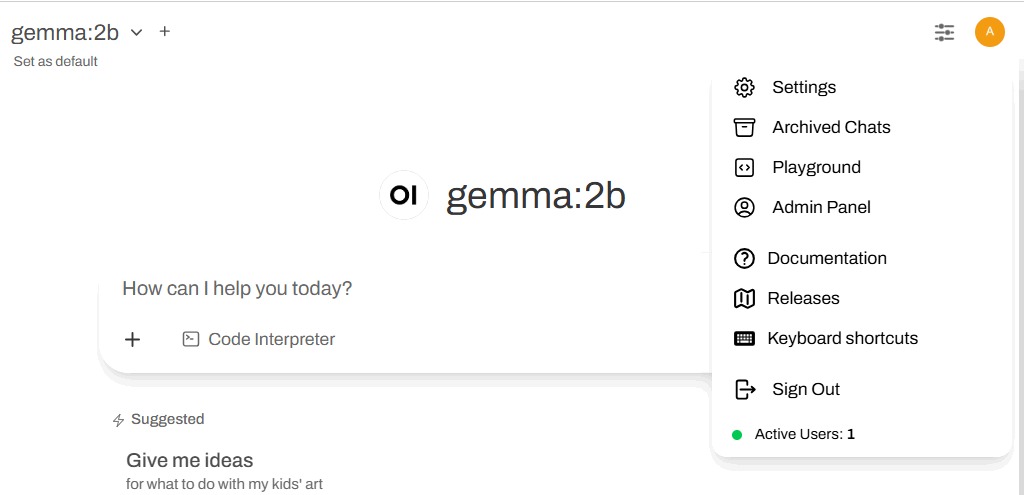

در این مثال، ما مدل gemma:2b را نصب میکنیم زیرا نسبت به مدلهای بزرگتر منابع کمتری مصرف میکند. برای این کار، روی آیکون پروفایل خود کلیک کنید و گزینه Admin Panel را انتخاب کنید تا به داشبورد مدیریتی دسترسی پیدا کنید.

روی آیکون دانلود در گوشه بالا-راست کلیک کنید تا مدل را دانلود کنید.

نام مدل را مشخص کنید و روی دکمه دانلود کلیک کنید.

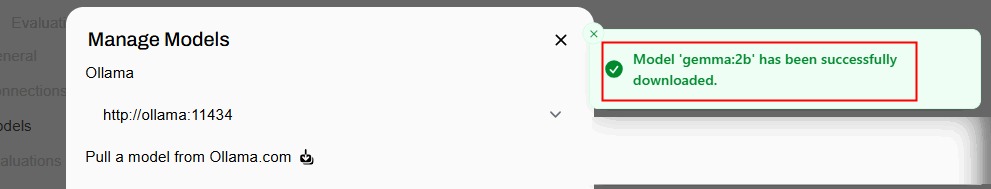

پس از دانلود موفقیتآمیز مدل، پیام موفقیت دریافت خواهید کرد.

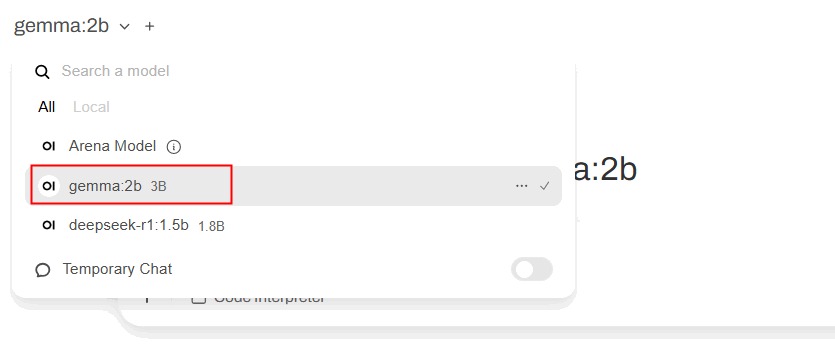

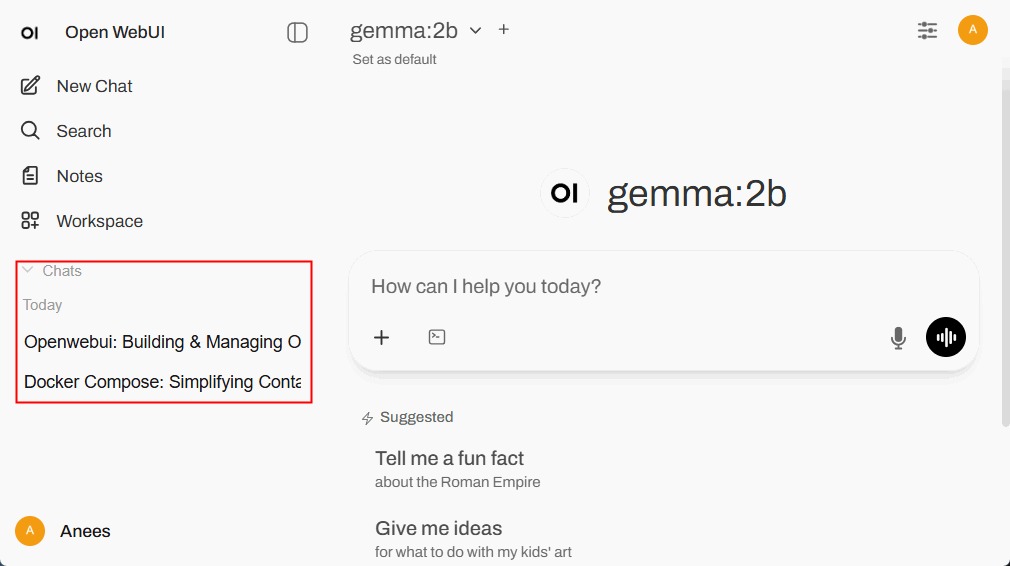

حالا میتوانید بهسادگی یک مدل را از رابط Open WebUI انتخاب کنید و برای پرسوجوهای خود از آن استفاده کنید.

نحوه استفاده از Open WebUI

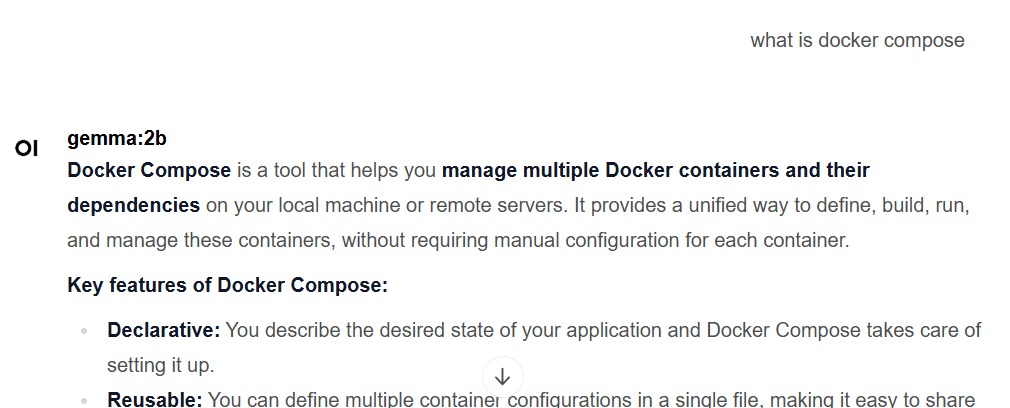

پس از انتخاب مدل، میتوانید شروع به پرسیدن سؤالات کنید. برای مثال، من پرسیدم “Docker Compose چیست؟” و Open WebUI پاسخ زیر را ارائه داد:

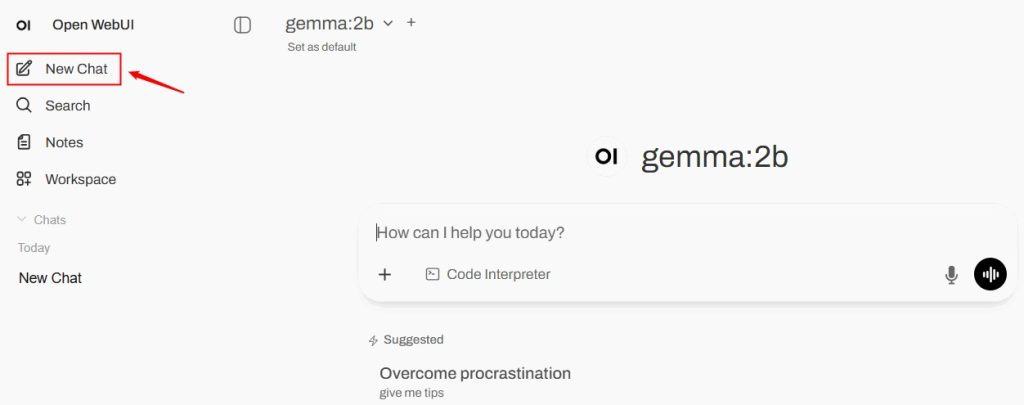

برای شروع یک گفتوگوی جدید بدون انتقال پیامها یا زمینههای قبلی، از منوی سمت چپ روی New Chat کلیک کنید. این ویژگی زمانی مفید است که بخواهید موضوع کاملاً متفاوتی را بدون تأثیر چتهای قبلی بحث کنید.

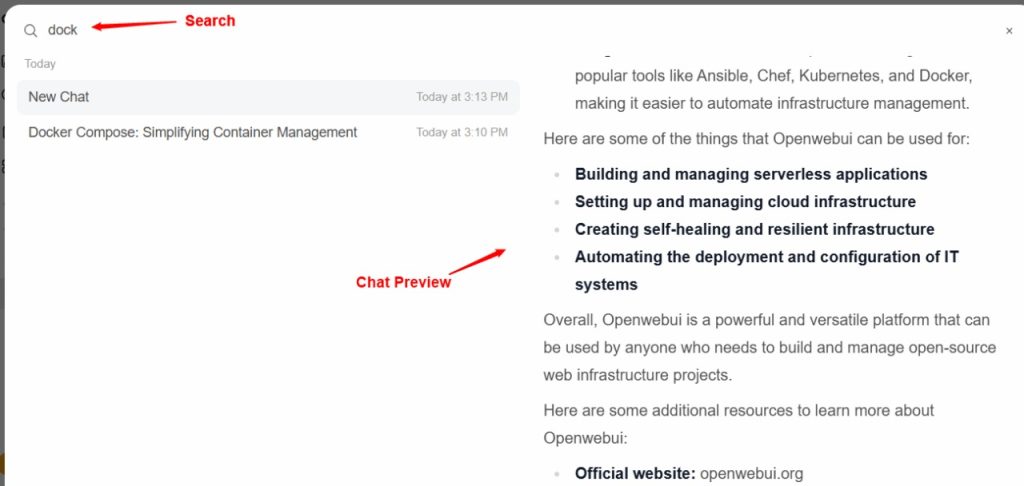

بخش Search به شما امکان میدهد گفتوگوهای گذشته یا کلمات کلیدی خاص را در چتهای ذخیرهشده پیدا کنید. برای این منظور، میتوانید یک کلمه یا عبارت را تایپ کنید و نتایج را فیلتر کنید تا بهسرعت پاسخها یا دستورات قدیمی را بازبینی کنید.

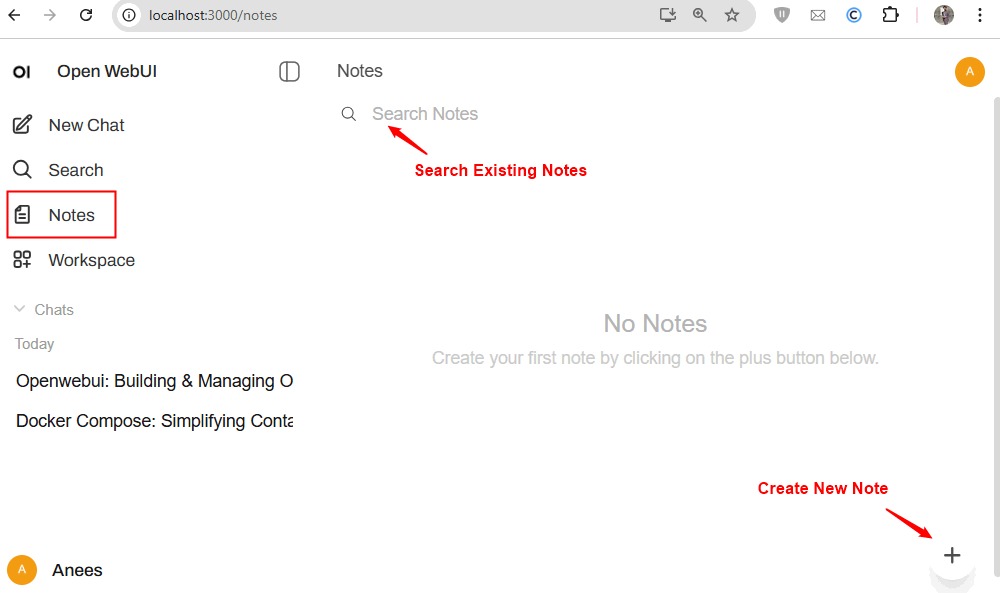

ویژگی مفید دیگر، Notes است. این یک نوتپد داخلی برای ذخیره متن، ایدهها یا مراجع است. این بخش جدا از چتها عمل میکند، بنابراین محتوایش بهعنوان زمینه گفتوگو استفاده نمیشود مگر اینکه آن را در چت جایگذاری کنید. این برای ذخیره یادآوریها، قطعات تحقیق یا دستورات پرکاربرد ایدهآل است.

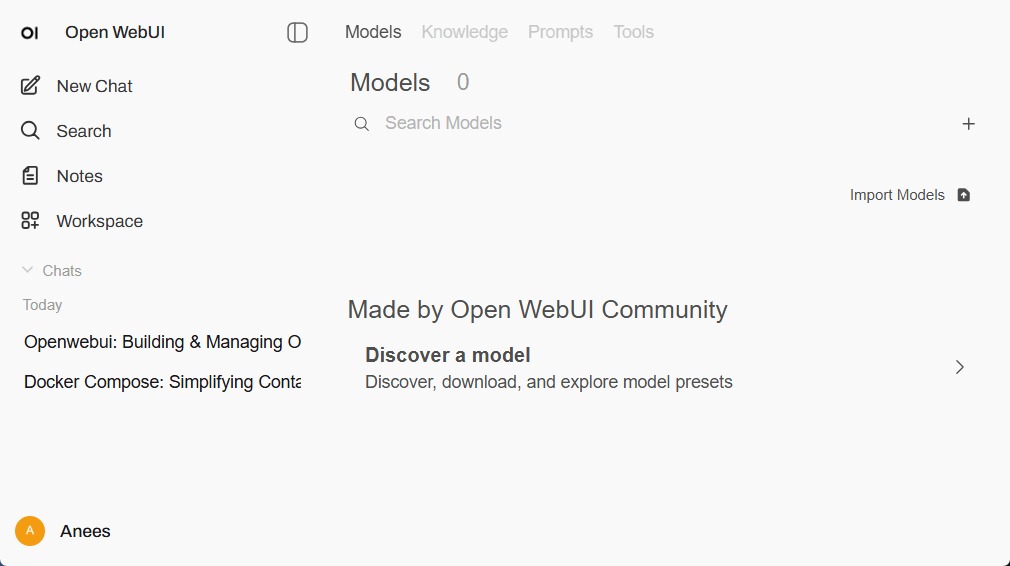

Workspace در Open WebUI فضایی سازمانیافته برای مدیریت چندین پروژه بدون مخلوط شدن آنهاست. این برای کدنویسی، نوشتن یا کارهای بلندمدت مفید است. Open WebUI شامل تبهای زیر است:

- Models Tab: کشف و دانلود مدلها یا پیشتنظیمات جامعه (community)، وارد کردن مدلها از منابع خارجی و پیکربندی مدلهای نصبشده.

- Knowledge Tab: مرور بستههای دانش جامعه یا وارد کردن فایلهای خود (PDF، متن، CSV) برای استفاده هوش مصنوعی در پاسخ به سؤالات.

- Prompts Tab: کشف قالبهای جامعه، وارد کردن دستورات و استفاده مجدد از آنها در چتها.

- Tools Tab: یافتن یا وارد کردن ابزارهایی مانند اجراکنندههای کد، اسکریپرها یا خلاصهسازها و استفاده از آنها مستقیماً در چتها برای خودکارسازی یا کارهای تخصصی.

- Chats: نمایش تاریخچه گفتوگوهای شما با هوش مصنوعی. میتوانید چتهای گذشته را باز کنید تا ادامه دهید یا آنهایی که دیگر نیاز ندارید را حذف کنید.

کنترلهای چت در Open WebUI

پنل Chat Controls به شما امکان میدهد نحوه پاسخدهی هوش مصنوعی در گفتوگو را تنظیم کنید. میتوانید یک System Prompt تنظیم کنید تا لحن یا رفتار را هدایت کند و پارامترهای پیشرفته مانند پاسخهای چت استریمینگ، اندازه قطعه، فراخوانی تابع، seed، توالی توقف، دما و تلاش استدلال را دقیق تنظیم کنید. هر پارامتر میتواند سفارشی شود یا برای رفتار استاندارد در حالت پیشفرض باقی بماند.

روی آیکون پروفایل کلیک کنید تا به منوی کاربر دسترسی پیدا کنید، که شامل گزینههایی برای تنظیمات، چتهای آرشیو شده، پنل ادمین، مستندات، نسخهها، میانبرهای کیبورد، خروج و مشاهده کاربران فعال است.

جمعبندی

Open WebUI نیاز به تنظیم اولیه دارد، اما پس از پیکربندی، کنترل کامل، حریم خصوصی و انعطافپذیری را ارائه میدهد. میتوانید مدلها را انتخاب کنید، از دادههای خود استفاده کنید و رابط کاربری را سفارشی کنید، همه بدون وابستگی به سرورهای شخص ثالث. پس از نصب مدل بهصورت محلی، میتوانید آن را کاملاً آفلاین اجرا کنید.

بیشتر بخوانید:

اجرای مدلهای هوش مصنوعی به صورت لوکال با استفاده از LM Studio

نحوه دانلود و نصب Fooocus | تولید تصویر هوش مصنوعی رایگان و آفلاین

نحوه استفاده از چت بات انویدیا NVIDIA Chat with RTX AI Chatbot در ویندوز